YouTube accusé d’appliquer des filtres sous IA aux contenus des utilisateurs

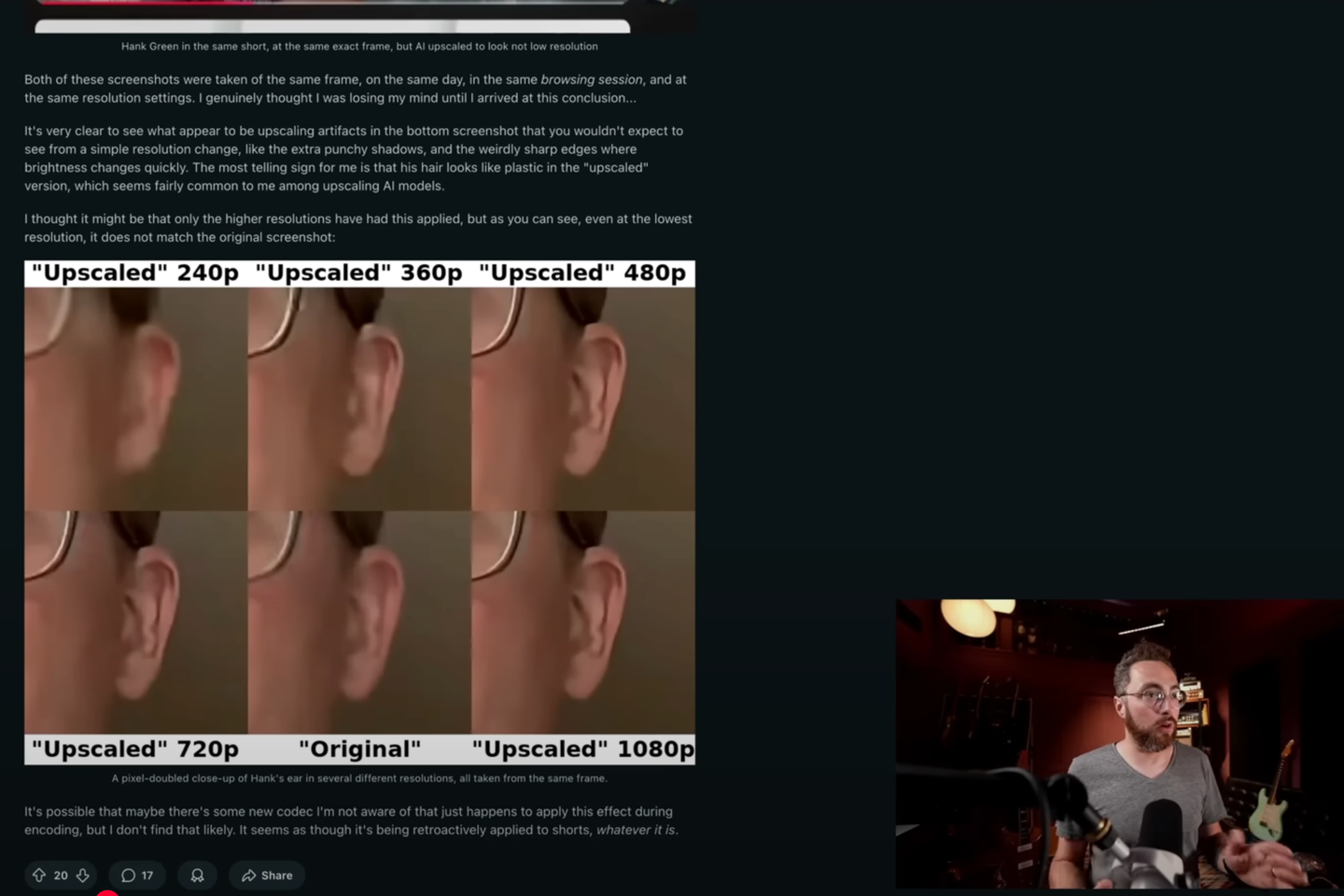

Dès le mois de juin, les premiers avertissements inquiets commencent à apparaître sur le forum Reddit. Quelques créateurs s’alarment de l’apparence des vidéos publiées récemment sur YouTube : certains y décèlent un effet « peinture à l’huile », d’autres un aspect « plastique » leur faisant penser à la marque d’un traitement par intelligence artificielle. Toutefois, il faut attendre mercredi 20 août, cette fois sur le réseau social X, pour que le soupçon se confirme. En guise d’expérimentation, l’entreprise utilise bien un « procédé traditionnel de “machine learning”pour déflouter, “débruiter” et améliorer la clarté » d’une partie des « shorts », les vidéos courtes et verticales de YouTube, révèle alors Rene Ritchie, chargé pour YouTube des relations avec les créateurs. En employant le vocable « machine learning », la plateforme se garde d’employer les termes « intelligence artificielle », qui évoquent sans doute trop les IA génératives, outils apparus dans les années 2020 et qui permettent de créer des vidéos de toutes pièces sur la base d’une simple consigne textuelle. A l’inverse, le « machine learning » peut passer pour une technologie plus traditionnelle, car il est Lire aussi | Article réservé à nos abonnés Avec Veo 3, les vidéos générées par IA deviennent quasiment impossibles à distinguer des vraies Ce type d’outil est pourtant bien une intelligence artificielle. Il partage même avec les IA génératives des soubassements techniques communs de sorte qu’il ne serait pas surprenant que leurs signatures visuelles respectives puissent être confondues. Perte de confiance C’est la raison pour laquelle les nouveaux filtres de YouTube font craindre aux créateurs des conséquences négatives sur leur communauté. « J’ai un énorme problème avec ça », réagit ainsi Rhett Shull, youtubeur qui compte près de 750 000 abonnés. « En ce moment, l’IA est au cœur d’un vif débat. Des personnes sont farouchement hostiles à cette technologie, à cause de son impact environnemental » et des questions de propriété intellectuelle qu’elle soulève, expliquait-il dans une vidéo publiée vendredi 15 août. Il vous reste 45.32% de cet article à lire. La suite est réservée aux abonnés.

#youtube #accusé #dappliquer #des #filtres

YouTube accusé d’appliquer des filtres sous IA aux contenus des utilisateurs

Dès le mois de juin, les premiers avertissements inquiets commencent à apparaître sur le forum Reddit. Quelques créateurs s’alarment de l’apparence des vidéos publiées récemment sur YouTube : certains y décèlent un effet « peinture à l’huile », d’autres un aspect « plastique » leur faisant penser à la marque d’un traitement par intelligence artificielle. Toutefois, il faut attendre mercredi 20 août, cette fois sur le réseau social X, pour que le soupçon se confirme. En guise d’expérimentation, l’entreprise utilise bien un « procédé traditionnel de “machine learning”pour déflouter, “débruiter” et améliorer la clarté » d’une partie des « shorts », les vidéos courtes et verticales de YouTube, révèle alors Rene Ritchie, chargé pour YouTube des relations avec les créateurs. En employant le vocable « machine learning », la plateforme se garde d’employer les termes « intelligence artificielle », qui évoquent sans doute trop les IA génératives, outils apparus dans les années 2020 et qui permettent de créer des vidéos de toutes pièces sur la base d’une simple consigne textuelle. A l’inverse, le « machine learning » peut passer pour une technologie plus traditionnelle, car il est Lire aussi | Article réservé à nos abonnés Avec Veo 3, les vidéos générées par IA deviennent quasiment impossibles à distinguer des vraies Ce type d’outil est pourtant bien une intelligence artificielle. Il partage même avec les IA génératives des soubassements techniques communs de sorte qu’il ne serait pas surprenant que leurs signatures visuelles respectives puissent être confondues. Perte de confiance C’est la raison pour laquelle les nouveaux filtres de YouTube font craindre aux créateurs des conséquences négatives sur leur communauté. « J’ai un énorme problème avec ça », réagit ainsi Rhett Shull, youtubeur qui compte près de 750 000 abonnés. « En ce moment, l’IA est au cœur d’un vif débat. Des personnes sont farouchement hostiles à cette technologie, à cause de son impact environnemental » et des questions de propriété intellectuelle qu’elle soulève, expliquait-il dans une vidéo publiée vendredi 15 août. Il vous reste 45.32% de cet article à lire. La suite est réservée aux abonnés.

#youtube #accusé #dappliquer #des #filtres